Elon Musk, le nouveau propriétaire du réseau social Twitter, vient d’ajouter de nouvelles mesures à son joujou pour le rendre plus rentable qu’avant et aussi pour le protéger et protéger les données publiées par les utilisateurs sur cette plateforme contre les scraping bots (ou le web scraping).

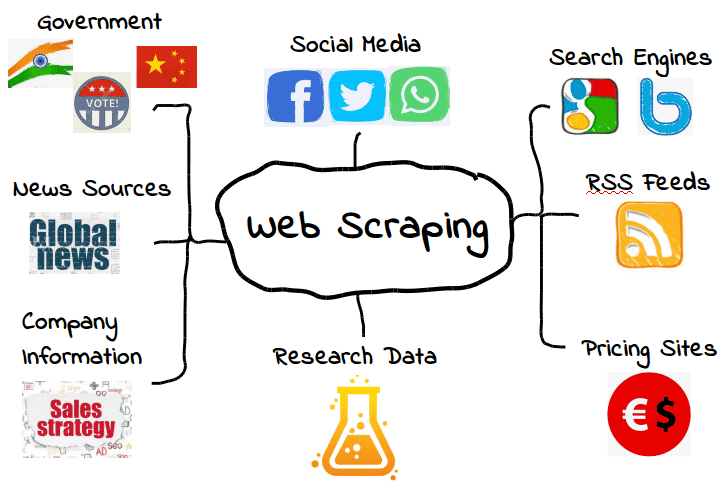

Le web scraping est une technique qui permet à des organismes, des entreprises ou même des particuliers de récolter et stocker de manière automatisée le contenu des sites web ou des services tels que les réseaux sociaux, les pages web, les forums, etc. Il s’agit de la même technique que les bots des moteurs de recherche utilisent pour indexer tout le contenu du web mondial afin de le traiter et de l’analyser avant de le fournir comme résultats aux recherches et requêtes des utilisateurs qui utilisent ces moteurs.

Dans le cas de Twitter, les données récoltées par ces bots sont généralement les tweets, les noms des utilisateurs et les pseudos utilisés, le nombre de Likes, le nombre d’abonnés et d’abonnements, etc.

Ces bots ne se contentent pas de récolter des données, mais ils consomment aussi beaucoup de ressources de la plateforme, tout comme les vrais utilisateurs. Et cela (avec le nombre énorme de bots qui traînent sur le web) peut mettre l’infrastructure technique du réseau social en péril. C’est pour cette raison que Elon Musk a d’abord restreint l’accès aux publications aux seuls utilisateurs enregistrés et authentifiés.

La deuxième mesure concerne le scrolling, le défilement à l’infini qui devient désormais limité par un nombre de tweets à visualiser par jour. En effet, un ancien utilisateur de Twitter (authentifié) peut désormais voir 600 tweets par jour, tandis qu’un nouveau qui vient de s’inscrire ne peut consulter que 300 tweets. Quant aux abonnés à Twitter Blue, ils ont accès à 6000 posts par jour.

Que pensez-vous de ces nouvelles restrictions ?