Alors que l’industrie de l’intelligence artificielle cherche à concilier rapidité et profondeur d’analyse, Anthropic, société cofondée par d’anciens membres d’OpenAI, dévoile Claude 3.7, un modèle présenté comme le premier à intégrer un raisonnement hybride. Ce modéle permettrait aux utilisateurs d’ajuster dynamiquement les ressources cognitives allouées par l’IA, selon leurs besoins en rapidité ou en précision.

Contrairement aux modèles classiques, qui opèrent souvent en boîte noire, Claude 3.7 propose un système de raisonnement modulable. Les utilisateurs peuvent contrôler le temps consacré à la réflexion, optimisant ainsi les coûts computationnels. Cette approche s’inspire de recherches récentes sur l’efficacité énergétique des IA, comme celles menées par l’Institut Allen pour l’IA, qui soulignent l’importance d’adapter les modèles à des contraintes pratiques.

Michael Gerstenhaber, responsable produit chez Anthropic, explique que cette flexibilité répond à des besoins variés : une réponse immédiate pour un chatbot client, ou une analyse détaillée pour un problème juridique complexe.

Parmi les fonctionnalités phares figure le scratchpad (ou « bloc-notes »), qui expose les étapes intermédiaires du raisonnement de l’IA. Cette transparence, déjà explorée par des projets comme IBM Watson ou Google’s LaMDA, vise à renforcer la confiance des utilisateurs et à affiner les requêtes. Dianne Penn, cheffe de recherche chez Anthropic, précise que cet outil est particulièrement utile pour des tâches techniques, comme le débogage de code ou l’analyse de contrats.

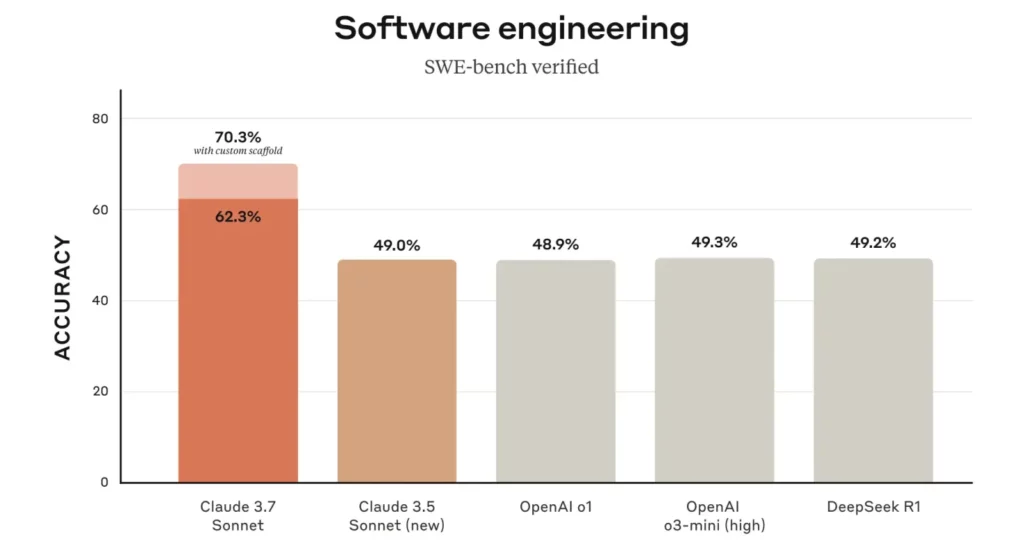

Claude 3.7 se distingue en unifiant raisonnement standard et approfondi, là où des concurrents comme OpenAI ou Meta utilisent des modèles distincts. Selon des benchmarks internes cités par Anthropic, il surpasserait l’o1 d’OpenAI sur des tâches nécessitant une planification rigoureuse, comme la génération de code ou la synthèse de documents juridiques.

Parallèlement, Anthropic lance Claude Code, un assistant de codage intégré au terminal, rivalisant avec GitHub Copilot ou Amazon CodeWhisperer. Cet outil mise sur une planification étape par étape pour réduire les erreurs, une approche saluée dans une étude récente de l’Université de Stanford sur l’IA générative.

Claude 3.7 incarne une tendance croissante vers des IA adaptatives et explicables, répondant à des exigences sectorielles variées. Anthropic renforce ainsi sa position face à des géants comme Google ou OpenAI, tout en alimentant les débats sur l’équilibre entre performance, coût et éthique. Reste à voir comment ces avancées s’intégreront dans des environnements professionnels exigeants, où la précision et la rapidité sont souvent antagonistes.

Cet article a été modifié pour la dernière fois le 26 février 2025 12h36